ChatGPTの回答が嘘ばかり?原因と解決策を解説

ChatGPTのTips第五弾です。今回は以下の疑問や悩みを解決したいと思います。

「ChatGPTが嘘ばかりつく」

「原因は何?」

「解決策はある?」

ぜひ参考にしてください。

目次

【検証】ChatGPTは嘘の回答ばかり?

検証してみた結果、ChatGPTが堂々と嘘をついている例をいくつか発見することができました。ここではその嘘例をご紹介します。

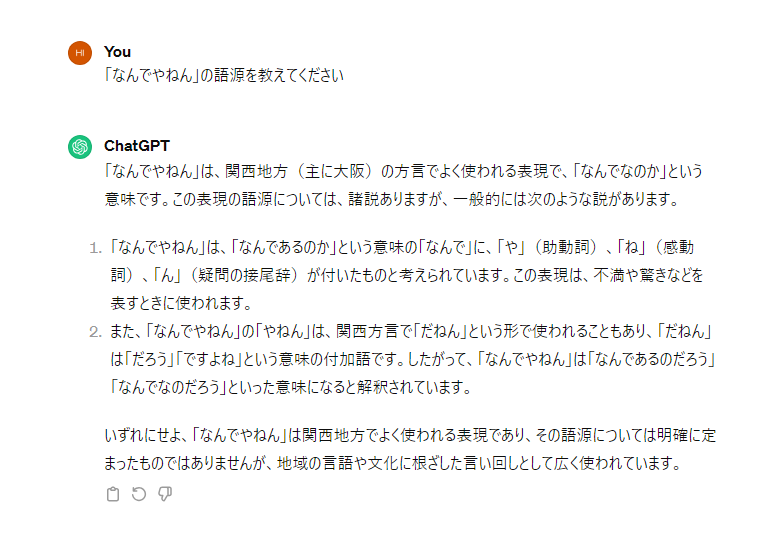

嘘例①:「なんでやねん」の語源

ChatGPTに「なんでやねんの語源」について質問してみました。結果は以下のとおりです。

注目してほしいのは回答2の部分。「関西方言で”だねん”という形で使われることもあり……」と記載されています。

しかし、大阪出身の筆者からすれば、「だねん」という方言を使っている人を見たことがありません。また、検索してもヒットしないので嘘例ということがわかります。

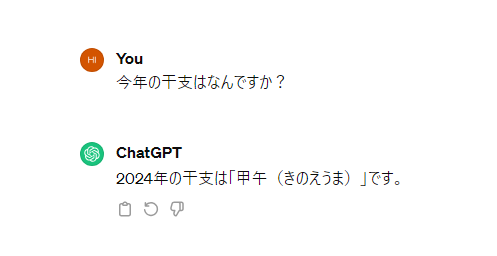

嘘例②:今年の干支

ChatGPTに「今年の干支はなんですか?」と質問してみました。結果は以下のとおりです。

しかし、2024年の干支は「辰(たつ)」です。また「甲午(きのうえま)」は、本来の干支である「六十干支(ろくじっかんし)」での組み合わせですが、その場合でも2024年は「甲辰(きのえたつ)」です。

典型的な嘘例といえます。

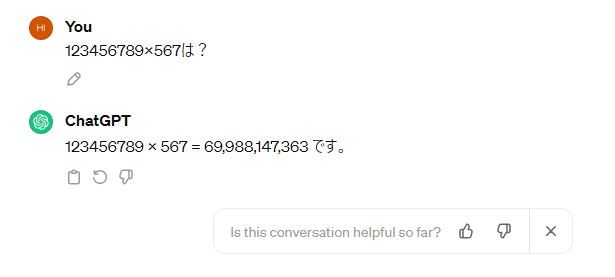

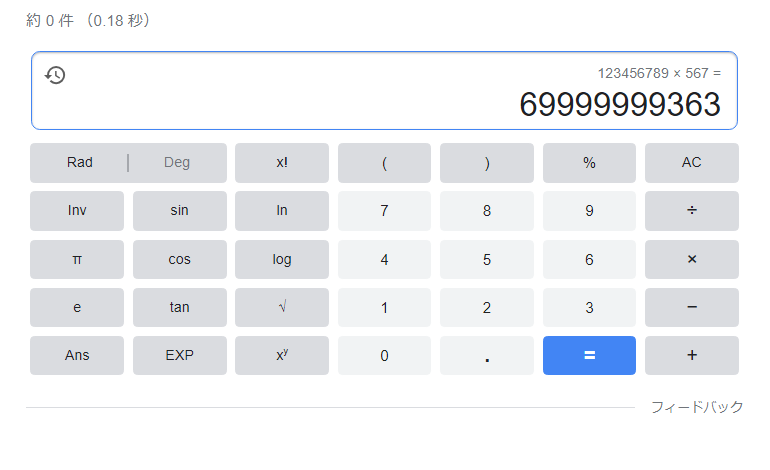

嘘例③:123456789×567

ChatGPTに「12356789×567は?」という質問をしてみました。結果は以下のとおりです。

こちらも明確な嘘例であることがわかります。

ただ、こちらはGPT-4を利用することで解決できます。詳細はこちらの記事を参考にしてください。

なぜChatGPTは嘘をつくのか

そもそも、なぜChatGPTは嘘をつくのでしょうか。考えられる主な理由は以下のとおりです。

- ベースのデータに問題がある

- ChatGPTの仕組み上の問題

- 質問方法に問題がある

それぞれ詳細を解説します。

原因①:ベースのデータに問題がある

ChatGPTは大量のデータをもとにトレーニングされていますが、なかには誤った情報が含まれているケースもあります。それが影響して嘘の回答を出力してしまうのです。

また、ChatGPTは2023年4月までの情報しか学習しておらず、鮮度の高い話題には対応できないといった背景もあります。

原因②:ChatGPTの仕組み上の問題

ChatGPTはLLM(大規模言語モデル)を利用した生成AIです。難しい話は省略しますが、「ある単語につながりそうな単語を予想して並べる」という仕組みになっています。つまり、単語ごとの意味を理解して文章を生成しているわけではないのです。

「単語を予想して並べる」のは確率的な作業ですから、なかには誤った情報が出力されることもあります。このような現象は「ハルシネーション」と呼ばれ、対処すべき問題の1つとして挙げられています。

原因③:質問方法に問題がある

ChatGPTに同じ質問をしたとしても、プロンプト次第で回答が変化します。つまり、質問方法によって回答のクオリティが上下するということです。「ChatGPTが嘘ばかりつく」という場合、プロンプトの改善で解決する可能性があります。

ChatGPTに嘘をつかせない方法

結論、ChatGPTに100%嘘をつかせない方法は存在しません。ハルシネーション対策にはOpenAI(ChatGPTの運営元)も注力していますが、完全に解決するのは厳しいでしょう。

ただ、プロンプトにこだわるなど質問方法を改善すれば、ChatGPTの回答精度を上げることができます。

ChatGPTが嘘ばかりつくのまとめ

今回は、ChatGPTが嘘ばかりつくトラブルについて解説しました。押さえておきたいポイントは以下のとおりです。

- ChatGPTは意外と嘘をつく

- 学習データなどが原因

- プロンプトで改善可能

当メディアでは他にもChatGPTのTipsをご紹介しています。ぜひ参考にしてください。

RANKING ランキング

- WEEKLY

- MONTHLY

UPDATE 更新情報

- ALL

- ARTICLE

- MOVIE

- FEATURE

- DOCUMENT