クロールバジェットとは?意識すべきサイトと必ず取り組みたい最適化の方法

Webサイトを運営していると、クロールバジェットという言葉を聞くことがあるでしょう。ですが、クロールバジェットとは何か、自分にはどのように関係するのか、よくわからないという方も多いのではないでしょうか。

そこでこの記事では、クロールバジェットとは何か、SEOとの関係性や最適化の方法を解説します。

Webサイトの記事がなかなかインデックスされなくて困っている、という方はぜひ参考にしてみてください。

目次

クロールバジェットとは

クロールバジェットとは、検索エンジンのクローラーがWebサイトをクロールできる上限のことです。

世界には、15億以上のWebサイトがあると言われています(参照元:Total number of Websites)。アクティブに稼働しているWebサイトはそこまで多くないとしても、膨大なWebサイトの全てをクローラーが巡回するのは現実的ではありません。

そのため、クローラーには1サイトでクロールできる上限として、クロールバジェットが存在します。

ただし、全てのサイトがクロールバジェットを意識しなければいけないということではありません。Google 検索セントラルでは、注意するべきサイトとして以下のように紹介されています。

大規模(重複のないページが 100 万以上)で、コンテンツが中程度に(1 週間に 1 回)更新されるサイト

中規模以上(重複のないページが 1 万以上)で、コンテンツがかなり頻繁に(毎日)更新されるサイト

Search Console で URL の大部分が検出- インデックス未登録に分類されるサイト引用元:Google 検索セントラル

記事がインデックスされなくて悩んでいる方は、ぜひ参考にしてみてください。

クロールとは

クロールとは、検索エンジンのロボットが行うWebサイトの巡回・調査のことです。

検索エンジンは、クロールによって収集・登録された情報を元に、Webページを検索結果に表示します。そのため、クロールが行われなければWebページが検索結果に表示されることはありません。

また、検索エンジンから適切な評価を受けるためには効果的にクロールされるための対策が必要です。

クローラーとは

クローラーとは、検索エンジンのクロールを行うロボットのことです。代表的なものとして、GoogleのGooglebot、BingのBingbotなどが挙げられます。ただし、日本でクローラーと呼ぶ場合はシェアが高いGooglebotを指すことが多いです。

本記事でも、主に「Googleのクローラーによるクロール上限」といった意味合いで解説しています。

クロールバジェットとSEOの関係性

クロールバジェットは、SEOと密接な関係があります。まず、そもそもクロールバジェットが低い場合、コンテンツのインデックスが行われないため、検索結果に表示されなくなってしまいます。

また、重要なコンテンツがクロール対象の記事から漏れてしまうと、根本的なSEO戦略の見直しが必要になるケースも考えられます。そのため、Webサイトの運営者にとってクロールの上限をあげることは死活問題と言えるでしょう。

特に、運営を始めたばかりのWebサイトは上限が低い可能性があります。そのため、まずはクローラビリティを高めたり、最適化を行う必要があります。

ただし、Webサイトにはクロールされる必要がないコンテンツが存在します。たとえば、同一商品の色違い・サイズ違いや、サイト内検索の結果ページなど、重複コンテンツや価値の低いコンテンツは、クロールの優先度が低くなります。そのため、意図的にクロールされないための設定が必要です。

SEOにおいて、実際に価値のあるページのみクロールされるように対策することで、クロールを効率化し、クロールバジェットが足りなくなるといった事態を避けられるでしょう。

クロールバジェットに対するGoogleの見解

クロールバジェットに対するGoogleの見解として「Google 検索セントラル」では以下のように説明しています。

「Googlebot が 1 つのサイトをクロールできる時間には限界があります。Google がサイトのクロールに費やす時間とリソースは、通常、サイトのクロール バジェットと呼ばれます。サイト上でクロールされたすべてのページが必ずしもインデックスに登録されるわけではありません。各ページを評価、統合、査定して、クロール後にインデックスに登録するかどうかを判断する必要があります。」

また、クロールバジェットを増やすための対策として、検索ユーザーにとってのサイトの価値を高めることが重要だと説明しています。

SEO対策には様々な取り組みがありますが、根本的な考え方はユーザーにとって価値のある情報を提供することです。クロールバジェットにおいても同様の考え方が適用されるため、テクニカルな取り組みだけではなく、コンテンツの質を高めていくことが大切です。

クロールバジェットを意識すべきサイトとは

クロールバジェットを意識するべきサイトとして、Googleは以下のサイトを挙げています。

- 大規模(重複のないページが 100 万以上)で、コンテンツが中程度に(1 週間に 1 回)更新されるサイト

- 中規模以上(重複のないページが 1 万以上)で、コンテンツがかなり頻繁に(毎日)更新されるサイト

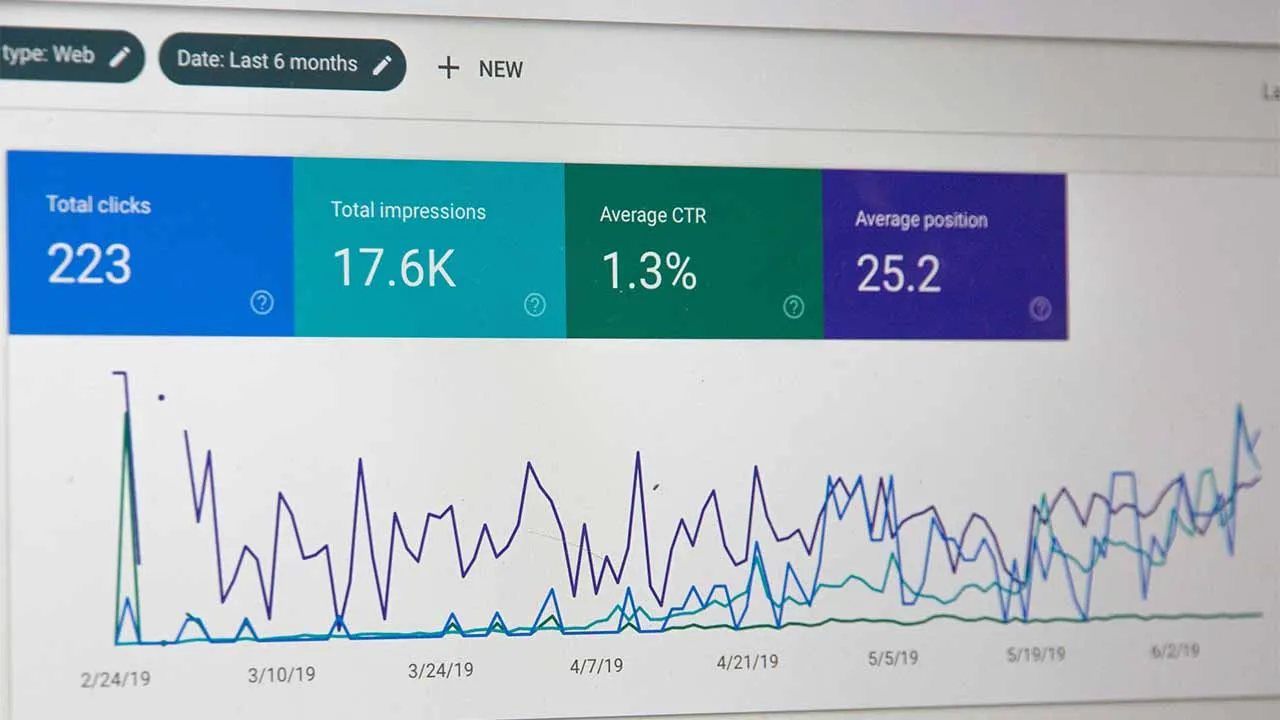

- Search Console で URL の大部分が検出- インデックス未登録に分類されるサイト

(引用元:Google 検索セントラル)

膨大なページが含まれるサイトやページ数が多く更新頻度が高いサイトは、クロールバジェットを意識する必要があります。一方で、数百ページ程度の個人サイトや中小規模の企業サイトであれば、クロールバジェットについて気にする必要はないといえます。

ただし、URLの多くが「検出- インデックス未登録」になっている場合は注意が必要です。特に、運用し始めたばかりのサイトや、似たコンテンツを大量に生成している場合は、「検出- インデックス未登録」が発生しやすいでしょう。

これから紹介する取り組みを実践することで、インデックスが加速する可能性があるため、ぜひ参考にしてみてください。

クロールバジェットに悪い影響を与える要素

クロールバジェットに悪い影響を与える要素は主に以下の8点が挙げられます。

- ファセット ナビゲーションとセッション ID

- サイト内の重複コンテンツ

- ソフトエラー ページ

- ハッキングされたページ

- 無限のスペースとプロキシ

- 質の低いコンテンツやスパム コンテンツ

- サイトの表示速度も重要

- nofollowは状況次第

上記の要素について、確認を行い、問題がある場合は改善することでクロールバジェットへの悪影響を取り除ける可能性があります。

各要素について、くわしく説明していきましょう。

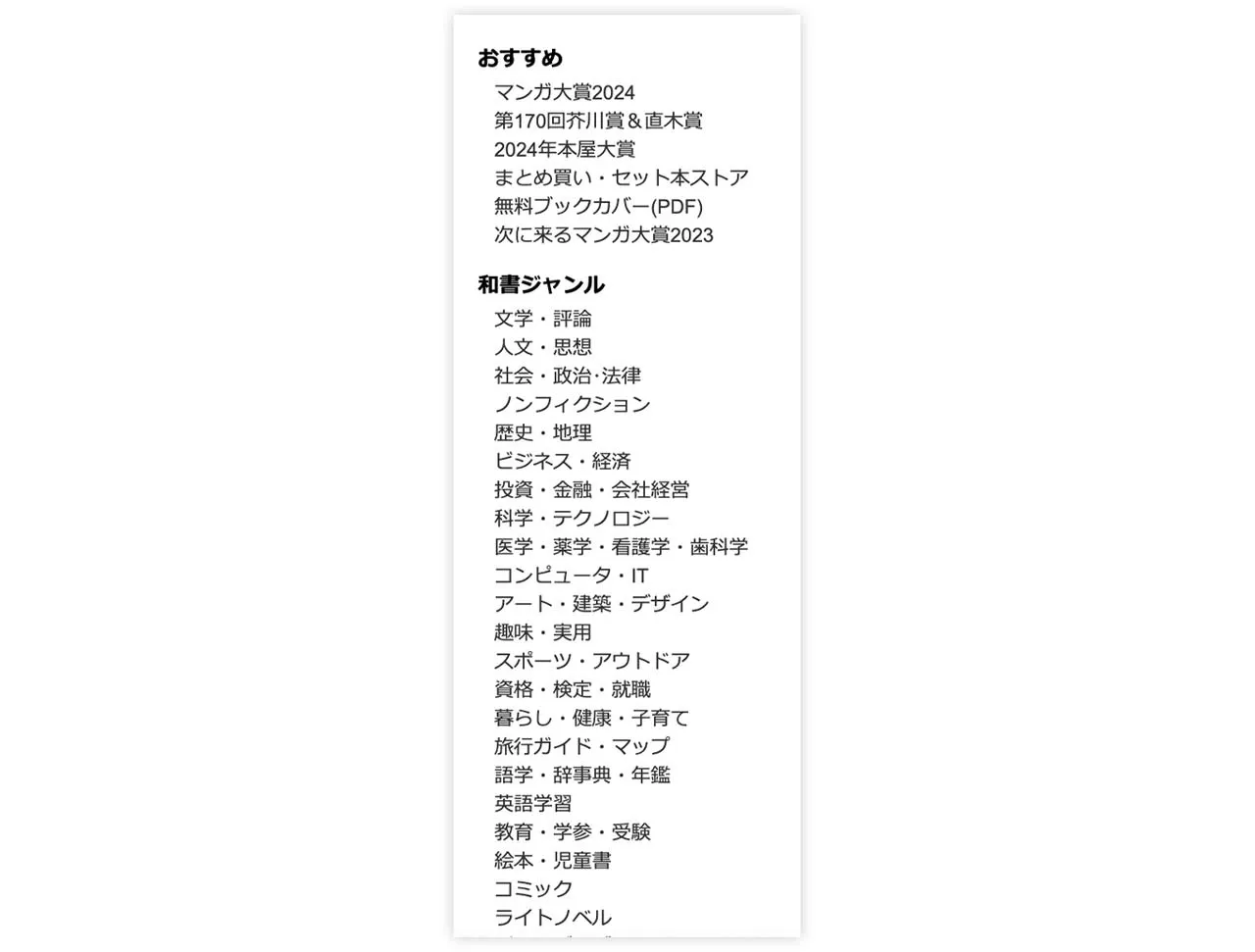

ファセット ナビゲーションとセッション ID

ファセットナビゲーションは、あらかじめサイト側が検索条件を提示し、ユーザーが条件に沿って絞り込んでいくことで自身が求めるページにアクセスできるものです。

ファセットナビゲーションは、検索条件の組み合わせによって膨大な重複ページを生み出してしまいます。

また、ユーザーの行動を識別するセッションIDがURLパラメーターに含まれる場合、複数のURLから重複コンテンツにアクセスできるようになり、クロールのリソースを無駄使いすることにつながるでしょう。

ファセットナビゲーションはクロールされないように対策してみてください。

サイト内の重複コンテンツ

サイト内の重複コンテンツもクロールバジェットに悪い影響を与える要素です。

重複コンテンツがあると不要なクロールが行われてしまい、クロールのリソースを無駄使いしてしまいます。

不要なクロールを避けるために、重複コンテンツは一つのページに統合する、必要ないページは削除する、あるいは重複コンテンツをクロールされないようにするといった対策を施してみましょう。

また、重複コンテンツはクロールバジェットの観点以外でも、被リンクの評価が分散することやユーザー体験の低下などSEOにおいて悪影響を及ぼす可能性があります。

したがって、重複コンテンツがないか確認し、ページの統合や不要なページの削除を進めてみてください。

ソフト404エラー

ソフト404エラーとは、Webページ上では「ページが見つかりません」と表示されますが、ステータスコードは200(問題なく処理された)となっている状態を指します。

ソフト404エラーはコンテンツが存在していませんが、クローラーは他のコンテンツがあるページと同様に継続的にクロールを行うため、リソースの無駄使いにつながるのです。

GoogleのGary Illyes氏も、LinkdInにてソフト404エラーはクロールバジェットを無駄に消費してしまうため、避けなければいけないと言及しています。(参照元:LinkedIn)

ソフト404エラーは放置せず、ステータスコードが404になるように対処しましょう。

また、コンテンツがほとんどないことやページの表示速度が著しく遅いこと、ページを開く際に大量のデータを読み込む必要があることなどが原因でソフトエラーページになることもあります。

ソフト404エラーの原因を確認し、適切に改善することでクロールバジェットへの悪影響を取り除くことができるでしょう。

ハッキングされたページ

ハッキングされたページがあることでクロールバジェットに悪影響を及ぼす場合があります。

ハッキングされたページ・コンテンツはサイトのセキュリティの脆弱性をつかれ、意図せず配置されたものを指し、ユーザーにとって有用ではありません。自社サイトにとってもクロールのリソースを無駄使いするコンテンツであり、クロールバジェットの観点から対処するべきでしょう。

自社サイトのセキュリティの問題を確認し、ハッキングされたページやコンテンツを迅速に修正、削除することをおすすめします。

また、ハッキングされたページやコンテンツを放置すると、ユーザーのパソコンに悪意あるコンテンツがインストールされることもあります。クロールバジェットに注意する必要性が低い個人のサイトや中小規模のサイトでもハッキングされたページの確認と修正は必要です。

無限のスペースとプロキシ

無限のスペースがあると、クロールバジェットに悪い影響を与えます。

無限のスペースは多数のリンクが無限に生成される状態です。たとえば、サイト内のカレンダーの「次の月」リンクから表示されたカレンダーの「次の月」リンクといったように、無限に新しいページが表示される状態を無限のスペースと呼ぶのです。

無限のスペースは価値ある新しいコンテンツを提供しない上に、クロールのリソースを無駄に使用します。無限のスペースがクロールされないように対策しておくことで、クロールバジェットへの悪影響を防止できるでしょう。

質の低いコンテンツやスパム コンテンツ

質の低いコンテンツやスパムコンテンツもクロールバジェットに悪影響を及ぼします。質の低いコンテンツの例は以下の通りです。

- 検索エンジンとユーザーに異なる情報を提供するコンテンツ

- ハッキングされたコンテンツ

- Googleのポリシーに反する隠しテキストや隠しリンクが含まれるコンテンツ

- 生成AIやプログラムによって自動生成されたコンテンツ

- 無断複製されたコンテンツ

- 内容が薄いアフィリエイトページ

上記のように価値が高くないコンテンツがサイトに多数存在すると、クロールバジェットに悪影響を与えるほか、ユーザー体験を低下させることにつながるためSEOの観点からも悪い影響があると考えられます。

質の低いコンテンツやスパムコンテンツはサイトから削除し、質の高いコンテンツのみをクロールされる状態を作ることが重要なポイントといえるでしょう。

サイトの表示速度も重要

サイトの表示速度が遅い場合、クロールバジェットに悪い影響を与えることがあります。

サイトの表示速度が速い場合はクロールの頻度が高くなることにくわえ、サーバーが健全な状態であると判断されて多くのコンテンツの取得が可能になるのです。つまり、クロールバジェットにとっていい影響があるといえます。

逆にサイトの表示速度が遅い場合やエラーが頻発する場合はクロール頻度が低下し、サーバーの状態に問題があると判断され、クロールバジェットに悪影響があるといえるでしょう。

サイトの速度を高めることはユーザーの利便性にもつながるため、サーバーエラーを抑え、可能な限り速い応答ができるように工夫するべきでしょう。

nofollowは状況次第

nofollowは状況次第でクロールバジェットに影響を与える場合があります。

nofollowは指定のリンク先をクロールしないように検索エンジンにヒントとして提示する属性値です。しかし、必ずしもクロールされないように命令できる設定ではありません。

nofollowを設定していても、自社サイト内の他ページや他のサイトからリンクを貼られた場合はクロールされる可能性があります。

「クロールされるURLはいずれもクロールバジェットに影響を与える」とGoogleは説明しているため、nofollowを設定したからといってクロールバジェットと無関係になるわけではありません。

クロールバジェットの最適化を行う方法

クロールバジェットの最適化を行う方法を6つ紹介します。

- robots.txtで除外する

- XMLサイトマップを更新する

- 低品質なコンテンツを改善する

- 404・410エラーの修正を行う

- ページの読み込み速度を改善する

- リダイレクトチェーンを避ける

価値が低くクロールする必要がないページにクローラーが巡回しないよう、上記の方法を実施してみてください。各方法についてくわしく解説していきましょう。

robots.txtで除外する

クロールされる必要がないページはrobots.txtでクロールから除外しましょう。robots.txtを活用することで、URLのクロールをブロックできます。

ファセットナビゲーションなどユーザーにとっては有用でも、検索結果に表示させる必要がありません。その他重複ページや無限のスペースなど、クロールバジェットに悪影響を及ぼすページはrobots.txtによってクロールをブロックしましょう。

ただし、robots.txtはインデックスされないように設定するものではありません。クロールをブロックすることはできますが、他のサイトから参照される場合はインデックスされる可能性があります。

クロールバジェットを最適化するためなのか、インデックスされないようにするためなのか、施策の目的・必要に応じてnoindexの活用も検討してみてください。

>>>robots.txtとは?SEOへの影響や使用する場面、設置方法などをわかりやすく解説

XMLサイトマップを更新する

XMLサイトマップを更新することもクロールバジェットの最適化につながります。XMLサイトマップは、人間向けのHTMLサイトマップと異なり、クローラー向けのサイトマップです。

クローラーは定期的にXMLサイトマップを確認していることから、XMLサイトマップの定期的な更新によって、ページの追加やコンテンツ更新をクローラーに迅速に伝えられる可能性が高まります。

XMLサイトマップはWordPressのプラグインや無料のツールでも作成可能ですし、自動生成・更新を行えるツールもあるため、必要に応じて活用してみてください。

>>>サイトマップとは?HTMLやXMLの違いや作成方法を解説!

低品質なコンテンツを改善する

低品質なコンテンツを改善することで、クロールバジェットの最適化を図れます。

低品質なコンテンツは重複コンテンツやユーザーにとって価値が低いコンテンツが該当します。低品質なコンテンツがクロールされることでクロールのリソースが圧迫され、クロールバジェットへの悪影響が予想されるのです。

重複コンテンツの統合や低品質ページの削除などを行い、価値が低いページへのクロールを防止しましょう。低品質コンテンツを改善することで、ユーザーの利便性が向上し、SEOの観点からも良い影響が期待できます。

クロールバジェットを意識する必要性が低いサイトでも低品質コンテンツを放置するべきではありません。

404・410エラーの修正を行う

404エラー・410エラーの修正を行うことで、クロールバジェットの最適化が期待できます。

404はページが見つからなかったこと、410は指定されたページが削除されたことをそれぞれ意味するエラーです。サイトのエラーが頻発する場合は、サイトの表示速度が遅い場合と同様に、クロールバジェットに悪影響があるとGoogle公式が説明しています

エラーページを修正することはクロールバジェットに良い影響をもたらすと考えられるため、404エラー・410エラーの修正をこまめに行いましょう。

ページの読み込み速度を改善する

ページの読み込み速度を改善することもクロールバジェットの最適化につながります。

クロールバジェットにはページの読み込み速度が影響することを先ほど説明しました。ページが高速で読み込めるほどクロール頻度が高くなり、多くのコンテンツを取得でき、結果としてクロールバジェットに良い影響が期待できます。

ページの読み込み速度を改善するためには、画像や動画のファイルサイズの最適化や遅延ロードの実装などさまざま方法があります。ページの読み込み速度を測定しながら施策を行い、改善の効果を測定しましょう。

リダイレクトチェーンを避ける

リダイレクトチェーンを避けることもクロールバジェットの最適化において重要なポイントです。

リダイレクトチェーンとは、URLからURLへ転送させるリダイレクトが複数回繰り返されることを意味します。リダイレクトチェーンが生じるとクロールの負荷が高まり、クロールバジェットに悪影響を及ぼすのです。

リダイレクトチェーンによってページの表示に時間がかかることは、クロールの負荷が高まること以外にユーザー体験の低下を引き起こすことも想定されます。

不要なリダイレクトページは削除し、Webサイトの構造を簡略にすることがクロールバジェットにおいてもユーザー体験においても重要なポイントです。

大規模サイトはクロールバジェットを意識しよう

クロールバジェットとは、検索エンジンのクローラーが1つのWebサイトをクロールできる上限です。

数百ページ以下の個人サイトや中小規模のサイトであればクロールバジェットを意識する必要はありませんが、数千・数万ページを超える大規模サイトはクロールバジェットを意識する必要があります。

検索にとって価値が低いページがクロールできる状態にあると、クロールのリソースが圧迫され適切な評価が得られない可能性があるのです。

したがって、大規模サイトは低品質コンテンツの改善やrobots.txtの効果的な活用によって、クロールの効率化を図り、クロールバジェットの最適化を狙いましょう。

RANKING ランキング

- WEEKLY

- MONTHLY

UPDATE 更新情報

- ALL

- ARTICLE

- MOVIE

- FEATURE

- DOCUMENT